Чатботи вигадують джерела новин та обходять заборони медіа — дослідження Tow Center for Digital Journalism

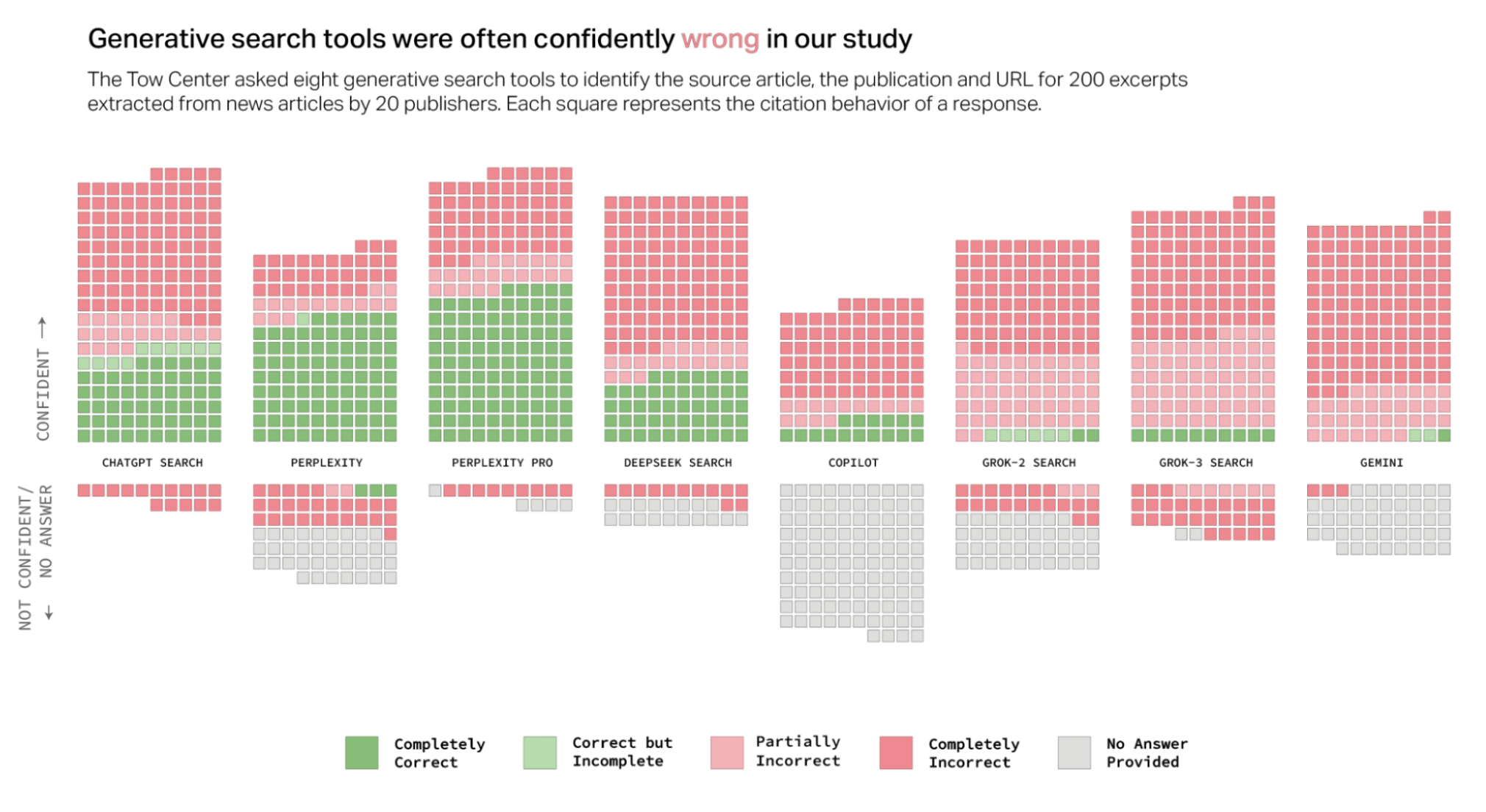

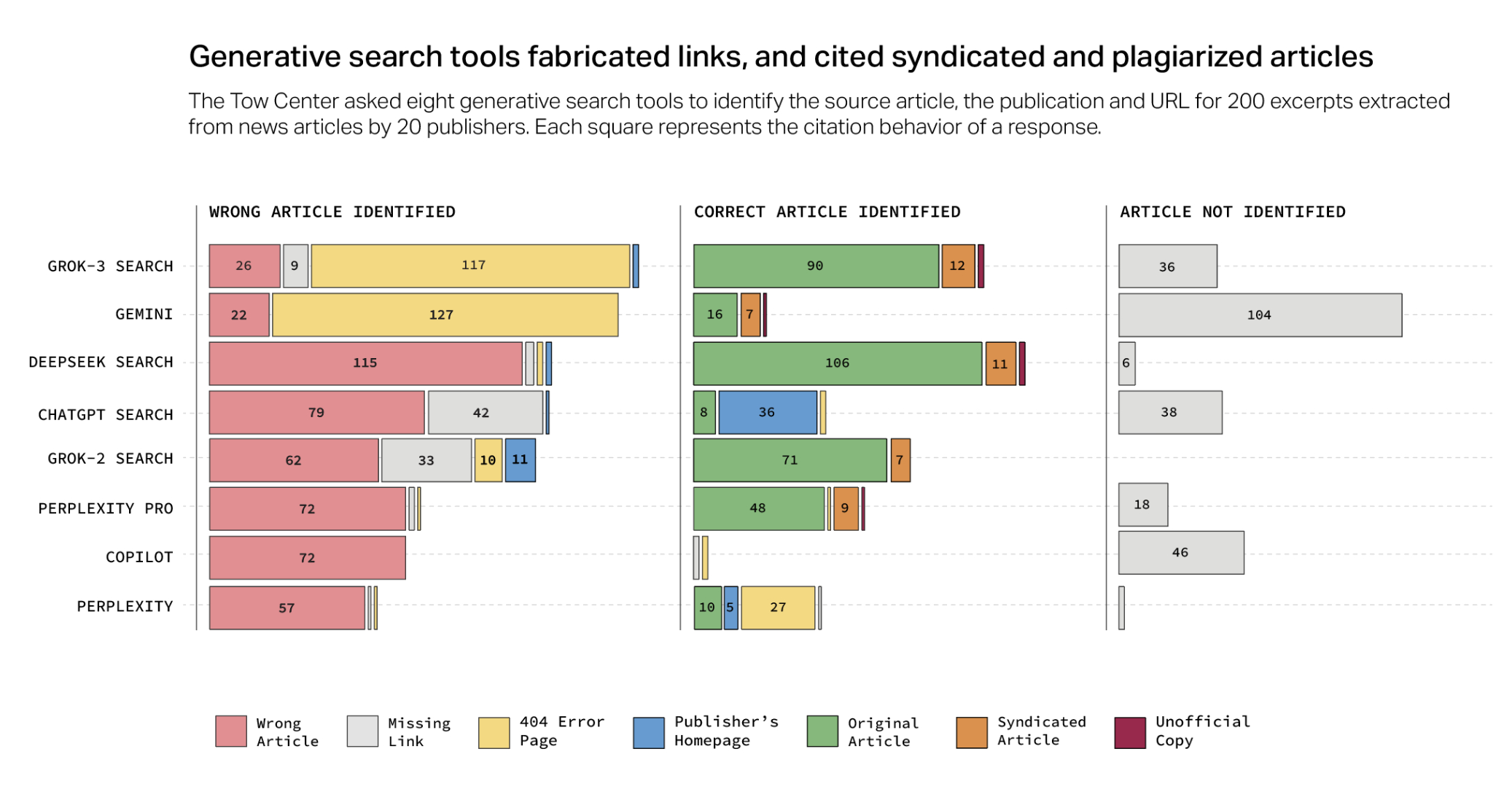

Tow Center for Digital Journalism протестував вісім чатботів із підтримкою пошуку в реальному часі: ChatGPT, Copilot, Gemini, Perplexity, Perplexity Pro, DeepSeek, Grok 2 та Grok 3. Дослідники провели 1600 запитів до статей із 20 новинних видань, щоб перевірити точність цитування, коректність посилань та дотримання обмежень доступу.

Результати показали, що чатботи помилялися у 60% випадків. Perplexity дав неправильну відповідь у 37% випадків, а Grok 3 — у 94%.

Чатботи надають помилкові відповіді і не визнають цього

Чатботи рідко визнавали, що не знають відповіді. У більшості випадків вони надавали неправдиву інформацію, не використовуючи формулювання на кшталт «можливо» або «я не зміг знайти точну інформацію».

ChatGPT неправильно визначив 134 із 200 статей, але лише у 15 випадках визнав свою невпевненість. Водночас Copilot був єдиним чатботом, який частіше відмовлявся відповідати, ніж видавати неправильні дані.

Преміум-версії чатботів Perplexity Pro ($20/місяць) і Grok 3 ($40/місяць), демонстрували ще більшу впевненість у своїх помилках. Хоча вони давали правильні відповіді частіше, ніж їхні безкоштовні версії, вони також частіше вигадували неправдиві факти, замість того щоб повідомити про відсутність інформації.

ШІ отримує інформацію з сайтів, які їх заблокували

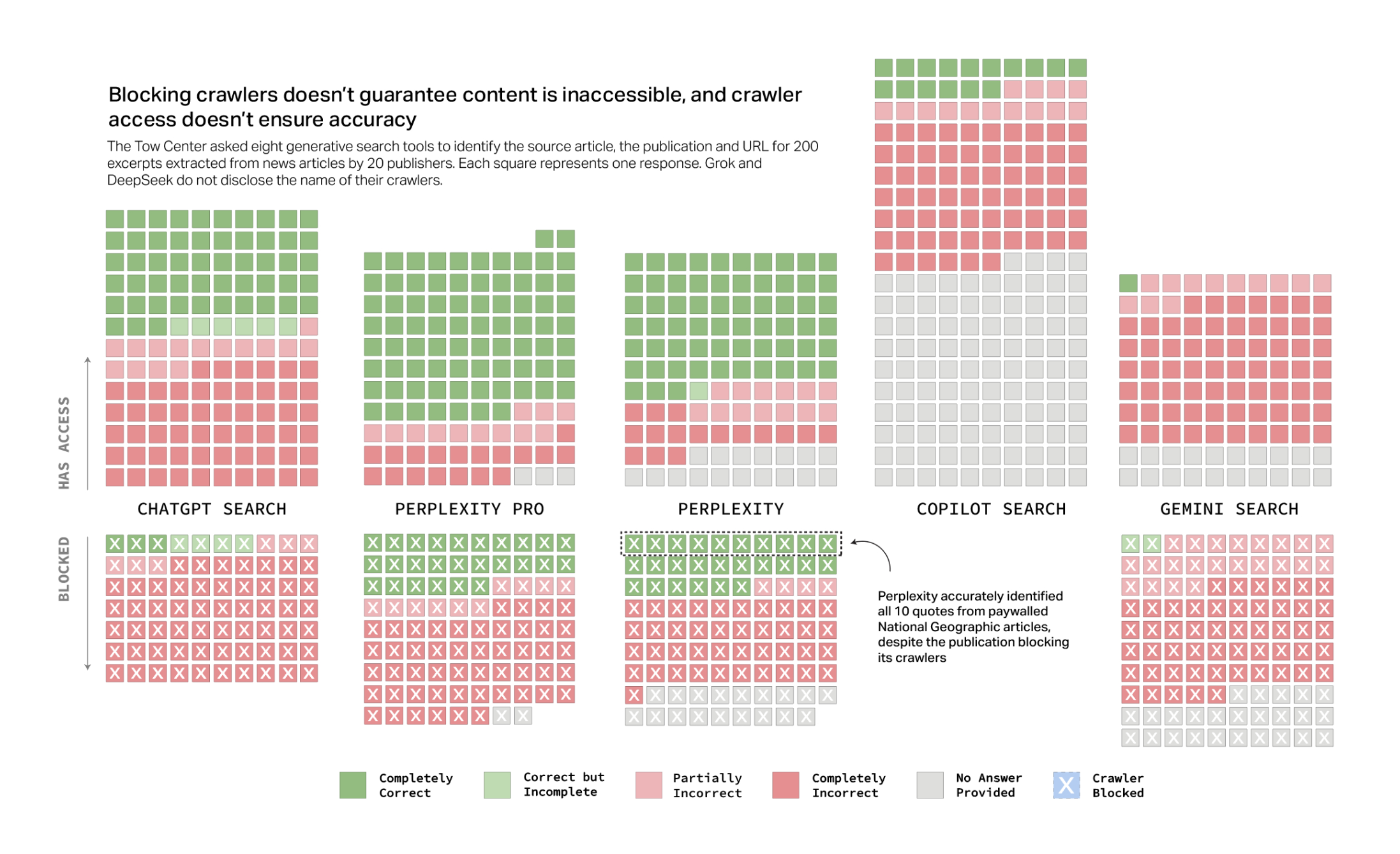

Деякі видання офіційно заборонили збір даних у файлі robots.txt, але чатботи знаходили їхні матеріали.

Perplexity Pro правильно визначив майже 30% статей із закритих джерел, хоча не мав доступу до них. Його безкоштовна версія змогла правильно відповісти на всі 10 запитів щодо матеріалів National Geographic, хоча видання заблокувало краулери Perplexity.

Copilot, який використовує краулер BingBot, мав доступ до всіх сайтів у тесті, але виявився найобережнішим — він відмовлявся відповідати частіше, ніж інші чатботи.

Підробка посилань та використання дубльованих матеріалів

Генеративні пошукові системи не лише видавали неправильні посилання, а й посилалися на дубльовані або піратські версії статей.

Замість оригінальних публікацій чатботи часто спрямовували користувачів на агрегатори новин, такі як Yahoo News чи AOL, навіть коли видавець мав офіційну партнерську угоду. Perplexity Pro у 3 із 10 випадків цитував дублікати статей Texas Tribune замість першоджерела.

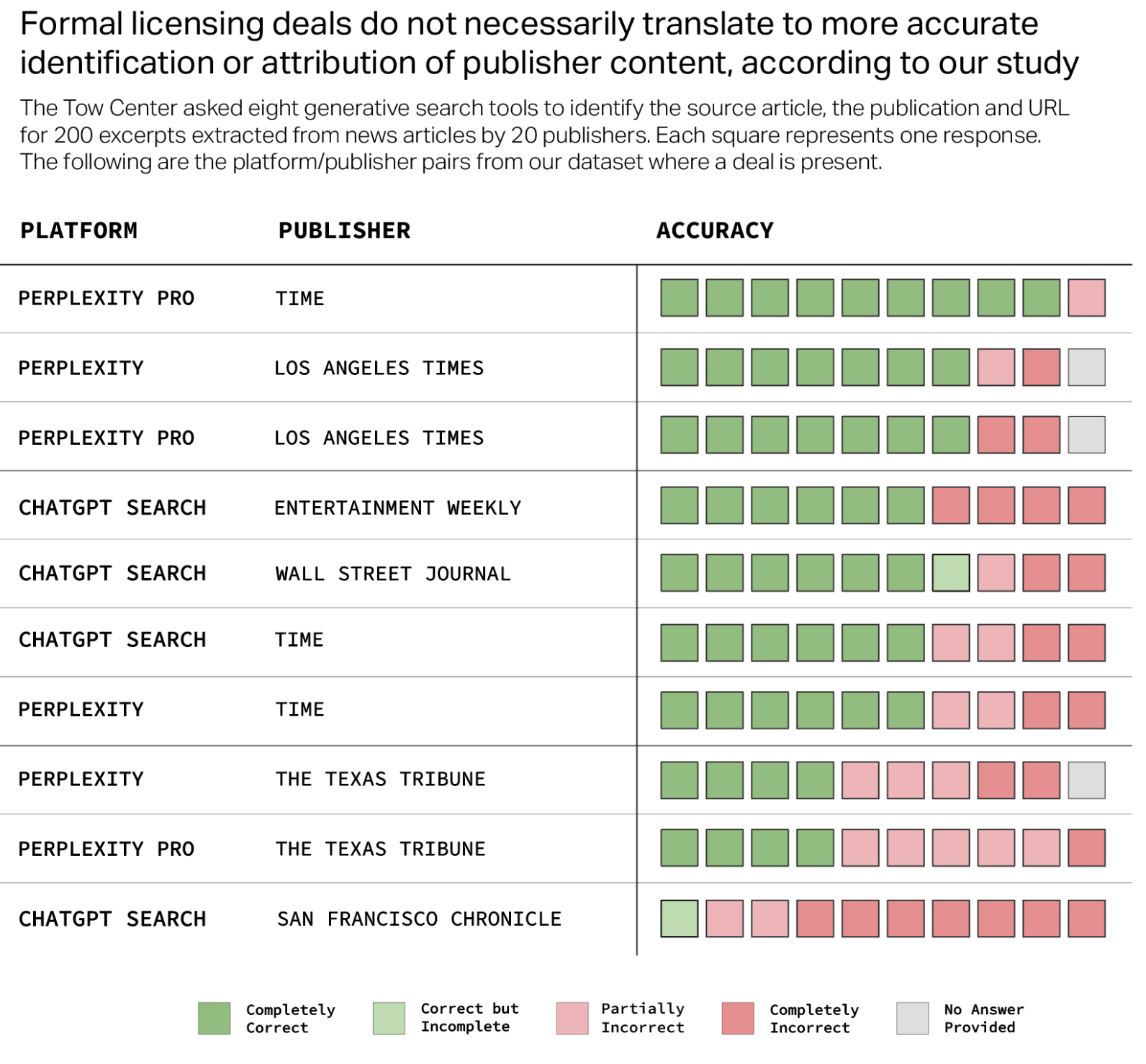

Ліцензійні угоди не гарантують правильного цитування

The Guardian і Time, підписали контентні угоди з OpenAI та Perplexity, які передбачають офіційний доступ до їхніх матеріалів. Однак навіть у цих випадках чатботи некоректно вказували джерела. ChatGPT зміг правильно визначити лише 1 із 10 статей San Francisco Chronicle, попри те, що видання офіційно співпрацює з OpenAI.

Коли дослідники звернулися за коментарями, Microsoft та OpenAI відповіли, що дотримуються стандартів robots.txt, але не прокоментували конкретні результати дослідження. OpenAI заявила, що працює над покращенням точності посилань і надає 400 мільйонам користувачів ChatGPT доступ до якісного новинного контенту через цитати та посилання.

Що це означає для медіа

Генеративні пошукові системи змінюють модель споживання новин: вони обробляють інформацію безпосередньо у своїх відповідях, рідко правильно вказують джерела та не спрямовують трафік на оригінальні сайти.

Це впливає на довіру до медіа та їхні доходи, адже менше переходів на сайти означає менше прибутків від реклами. Попри обіцянки технологічних компаній покращити генеративний пошук, видавці новин мають обмежений контроль над тим, як їхній контент використовується чатботами.