10 схем, де ШІ став співучасником шахрайств — чого варто остерігатися, щоб не стати жертвою

Нещодавно завірусилася новина про француженку, яка стала жертвою дипфейк-шахрайства зі штучним інтелектом, і втратила понад $830 тисяч. Проте це не один випадок, коли ШІ стає співучасником злочину, адже за прогнозами, до 2027 року збитки від шахрайства, керованого штучним інтелектом, можуть сягнути 40 мільярдів доларів США.

Ми зібрали кілька випадків шахрайств, у яких був залучений ШІ, а також поради, як виявити зловмисників і не стати їх жертвою.

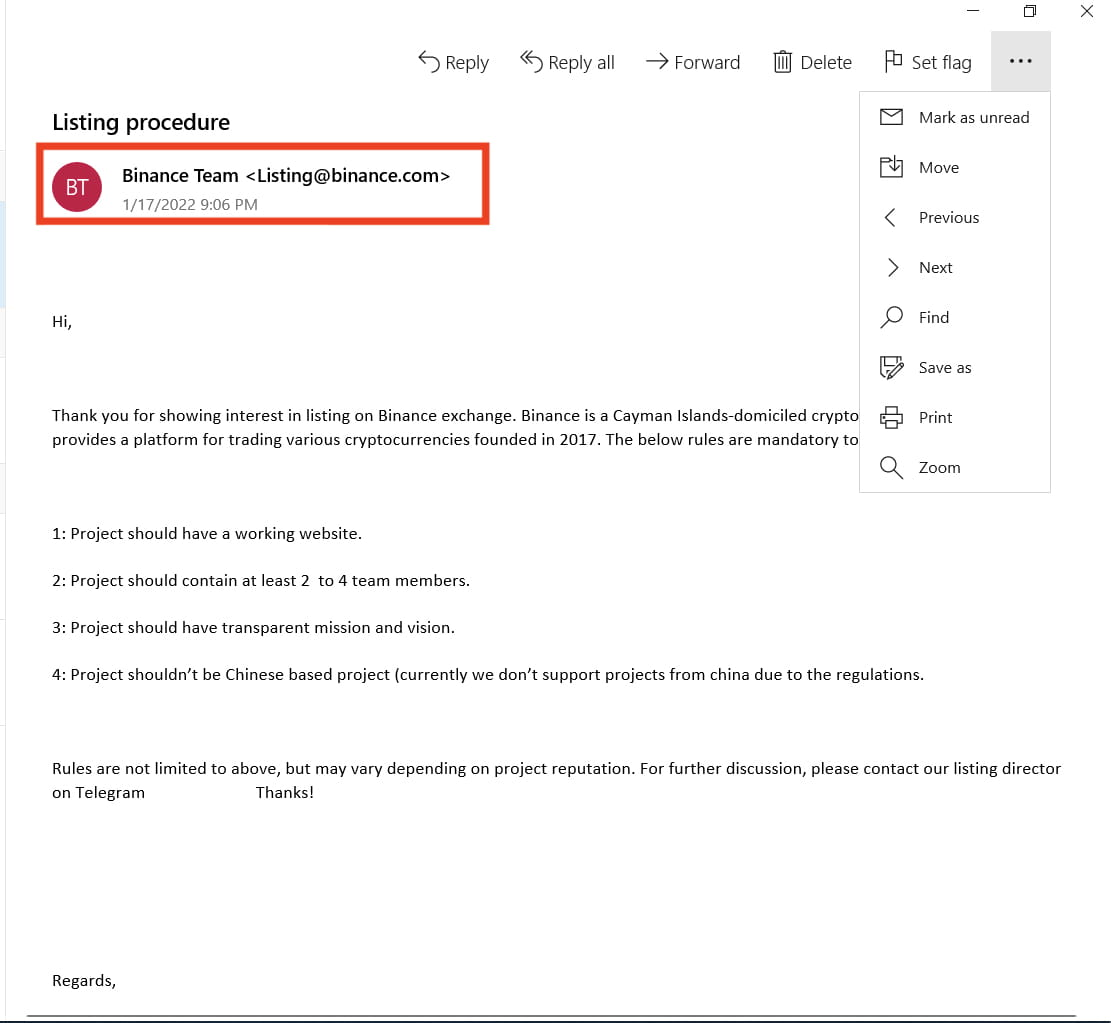

Фішинг в email

Фішинг — одна з найпоширеніших кіберзагроз, ігнорування якої призводить до витоку даних, фінансових втрат і репутаційних ризиків. З розвитком ШІ такі листи створювати стало простіше, тому кількість атак збільшилася.

Фішингові листи часто маскуються під офіційні сервіси: Google, PayPal, YouTube тощо. Зазвичай вони мають наповнення, яке спонукає перейти за посиланням чи завантажити шкідливий файл. Проте листи можуть мати різний вигляд — HTML-листівки, пропозиції співпраці, повноцінні копії офіційних повідомлень із логотипами, стилістикою та підробленими кнопками.

Як виявити фішинговий лист:

- зверніть увагу на email-адресу, з якої надіслано лист — фішингові листи можуть копіювати офіційні email, проте в них будуть траплятися помилки і знаки, яких не буде в офіційних адресах. Наприклад, security-update@paypa1.com — має 1 замість l, це має насторожити;

- логотип та стилістика листа — можуть як відрізнятися, так і копіювати офіційні, але отримати логотип BIMI (Brand Indicators for Message Identification) для email непросто, але більшість офіційних компаній його мають, на відміну від шахраїв;

- мова листа — фішингові листи діють на страх, відчуття тривоги, радість тощо. Вони спонукають зробити дію і якнайшвидше — змінити пароль, завантажити щось, перейти на сайт терміново. Таких листів потрібно остерігатися;

- вкладені файли та посилання — .exe, .html, .scr, .js або архіви — можуть містити вірус або скрипт, тому не варто відразу їх завантажувати чи відкривати;

- запит на особисту чи конфіденційну інформацію у листі — жодна легітимна компанія не проситиме в email ввести PIN-код, повні дані картки або пароль.

Якщо бачите подібний лист — не відповідайте на нього і не натискайте на посилання, не звантажуйте файли тощо. Проігноруйте або видаліть. Якщо ж фішинг стосується роботи — повідомте підтримку свого відділу, щоб вони зафіксували випадок.

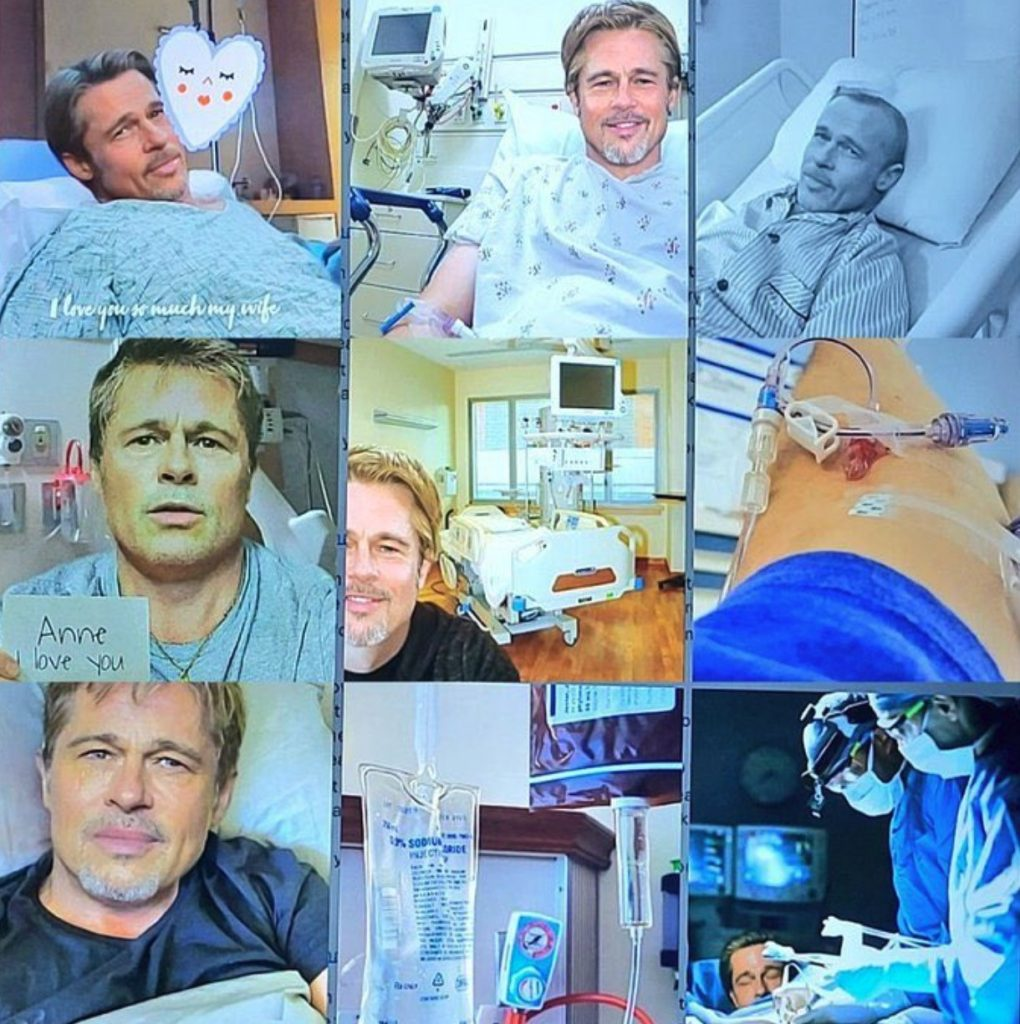

Романтичні афери з використанням ШІ

Шахраї можуть використовувати ШІ, щоб створювати фейкові особистості — з фото, відео та голосами, які важко відрізнити від реальних.

Британка втратила $25 000 після знайомства на Tinder з фейковим полковником США, створеним за допомогою ШІ. Шахрай надсилав реалістичні ШІ-відео і вів особисту переписку, запевняючи що гроші потрібні йому для доставки цінного вантажу.

Француженка втратила $830 тисяч, повіривши, що спілкується з Бредом Піттом. Шахраї використовували ШІ-фото, відео та фальшиві новини, переконуючи її надсилати гроші нібито на лікування. Після викриття вона зазнала хвилі насмішок, тричі намагалась вчинити самогубство.

Найчастіше такі схеми мають спільні ознаки:

- привабливі профілі — з фото моделей, військових, лікарів або знаменитостей;

- швидке емоційне зближення — уже на другий день переписки зізнаються в коханні;

- раптова поява відео, де ваш співрозмовник називає ім’я чи згадує деталі розмови;

- прохання про гроші — під виглядом сплати митних зборів, медичних витрат або вкладу у спільне майбутнє;

- спілкування через зашифровані месенджери (Signal, Telegram) та уникання відеодзвінків у реальному часі.

ШІ дозволяє шахраям імітувати поведінку, мову та емоції реальних людей, що робить обман переконливішим. Якщо сумніваєтесь у справжності людини — запропонуйте відеодзвінок у режимі реального часу, перевірте фото через Google Зображення, поставте несподівані запитання. Це допоможе виявити зловмисника.

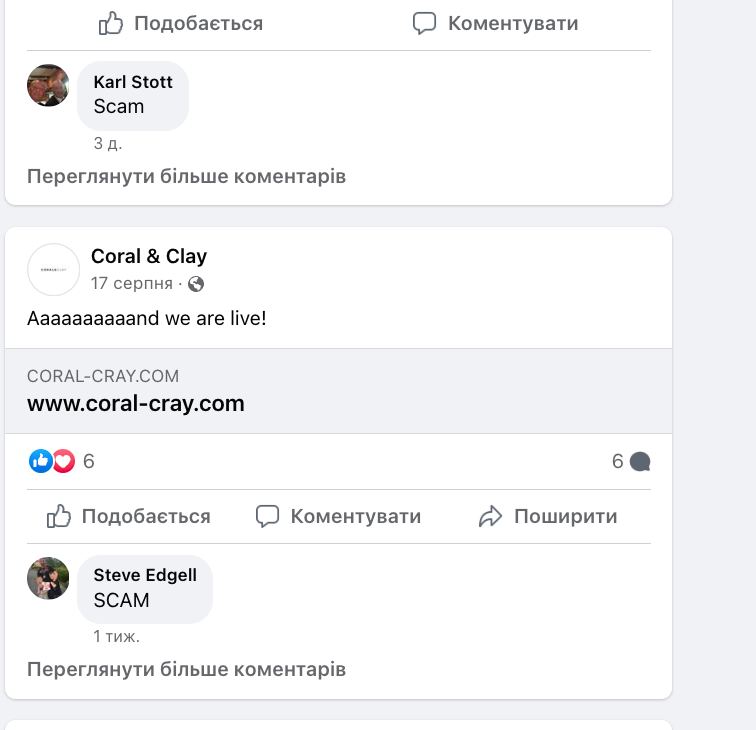

Фейкові відгуки, створені штучним інтелектом

Штучний інтелект також використовують для створення фальшивих відгуків на маркетплейсах, картах Google і навіть у блогах компаній. Такі тексти важко відрізнити від реальних: часто вони граматично правильні, містять емоційну оцінку й виглядають переконливо.

ШІ дозволяє генерувати тисячі відгуків з урахуванням заданого тону, ключових слів і навіть вигаданого досвіду використання продукту. Їх використовують для штучного підвищення рейтингу товарів або компаній, зниження довіри до конкурентів, а також маніпуляцій.

Ознаки фейкових ШІ-відгуків:

- загальні або надто шаблонні формулювання, без чітких фактів;

- надмірна або неприродна емоційність у текстах;

- однотипні фрази в кількох відгуках, написаних різними особами;

- відсутність деталей, притаманних реальному досвіду (наприклад, опис процесу замовлення чи конкретної проблеми);

- підозріло висока або низька оцінка без пояснення причин;

- аномальна активність — десятки нових відгуків за кілька годин чи день.

Фейкові відгуки ускладнюють розуміння цінності продукту та його переваг для покупців. Також вони можуть підштовхувати до шахраїв — зацікавити дієвістю певного продукту чи замовити щось в неіснуючому магазині.

Шахрайство з клонуванням голосу

У жовтні 2024 року чоловік втратив $25 000 через нову форму телефонного шахрайства — клонування голосу за допомогою штучного інтелекту. Шахраї зателефонували, використавши синтезований голос, який точно відтворював манеру мовлення та інтонації його сина. Шахрай повідомив про термінову ситуацію та попросив переказати гроші.

У 2019 році шахраї застосували клонування голосу, щоб імітувати голос генерального директора британської енергетичної компанії. Підроблений голос наказав переказати 220 000 євро на рахунок в угорському банку.

Такі випадки стають дедалі частішими, особливо в умовах війни. Сучасні ШІ здатні відтворити голос людини лише за кілька секунд аудіозапису. Злочинці отримують фрагменти з соцмереж, відео або месенджерів і створюють копії, які складно відрізнити від реального голосу.

Як розпізнати клонування голосу:

- дзвінок із невідомого або прихованого номера;

- підозріло термінові прохання — з емоційним тиском;

- прохання не дзвонити іншим членам родини або «не зволікати»;

- незвичні фрази, помилки або дивна логіка в розмові.

У разі такого дзвінка варто одразу перетелефонувати близькій людині напряму. Під час самого ж дзвінка можна задати кілька особистих контрольних питань, відповіді на які відомі лише вам.

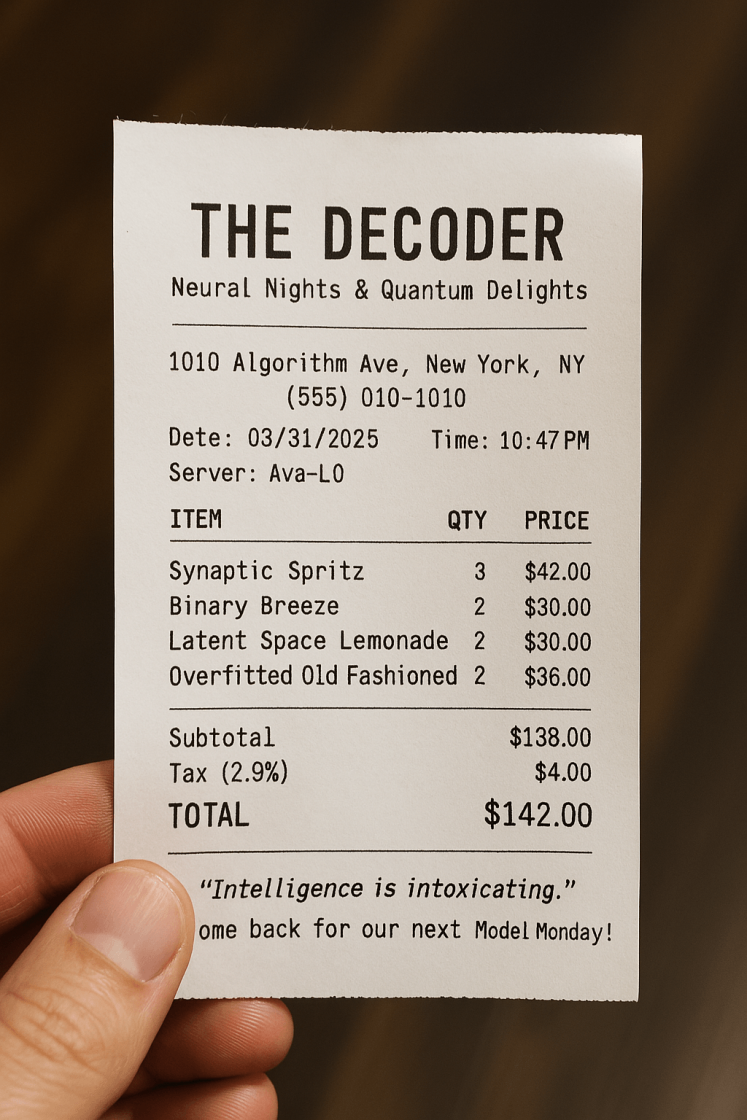

Підробка чеків за допомогою ШІ

Штучний інтелект уже використовується для створення фейкових документів — банківських квитанцій, медичних довідок, дипломів, рахунків і навіть паспортів. За даними The Decoder, нові моделі OpenAI дають змогу згенерувати підроблений документ за кілька секунд.

Шахраї можуть використовувати такі документи для обману продавців, роботодавців, страхових компаній або державних установ.

Як це працює:

- Шахрай завантажує шаблон справжнього документа.

- Змінює дані — ім’я, дати, суми, підпис.

- Генерує зображення за допомогою ШІ.

- Надсилає підробку як доказ.

Такі документи складно відрізнити від справжніх — вони виглядають переконливо навіть для досвідченого працівника. Метадані (мітки, що вказують на ШІ-генерацію) можна видалити, тому стандартна перевірка часто не спрацьовує.

Щоб захистити себе:

- перевіряйте документи через офіційні джерела (банки, реєстри, медзаклади);

- якщо є сумнів — запитайте оригінал у паперовому вигляді або зверніться до організації, яка нібито його видала;

- не приймайте критичні рішення (виплата, укладання договору, працевлаштування) лише на основі надісланого PDF або фото.

У крайньому разі ви можете попросити зняти відео з чеком, або перевірити чек через банк.

ШІ-порнографія

У серпні 2024 року в Південній Кореї виявили масштабне розповсюдження порнографічних зображень, створених за допомогою технології дипфейк. Жертвами стали вчителі та студентки, чиї фотографії були використані для створення ШІ-порно. Зображення поширювалися через Telegram. Цей випадок повпливав на законодавство країни.

Deepfake-порно важко відрізнити від реального відео. Багато хто сприймає його як правду, особливо якщо йдеться про публічних осіб, викладачів чи підлітків. Жертви часто не знають, що їхнє зображення використовують — допоки файл не з’являється в мережі.

Як захистити себе від створення дипфеків:

- Обмежуйте публікацію фото у високій якості.

- Увімкніть приватність у соцмережах, щоб сторонні не могли завантажити зображення.

- Якщо deepfake вже створено — зафіксуйте докази й зверніться до кіберполіції або юриста.

Не ігноруйте проблему — чим раніше виявити поширення, тим більше шансів на видалення матеріалу.

Фейкові ШІ-артисти на стримінгах

У музичній індустрії з’являються фейкові виконавці, створені повністю за допомогою ШІ. Їхні композиції завантажують на стримінгові платформи, де вони імітують справжню музику й отримують прослуховування. Усе — задля того, щоб автоматично отримувати роялті й красти гроші, які мали б належати реальним артистам.

У 2024 році на The Verge вийшла стаття про те, що алгоритми Spotify та інших платформ активно використовуються для монетизації таких ШІ-треків. Часто ці пісні розміщують у релакс-плейлистах або під виглядом фонового контенту — їх не слухають навмисно, але платформа все одно нараховує виплати.

Це шахрайська схема, що знецінює працю справжніх музикантів і підриває довіру до стримінгових сервісів.

Маніпулятивне використання ШІ в політиці для дезінформації

Штучний інтелект використовують у політичних кампаніях для створення фейкових заяв, відео та новин, що підривають довіру до офіційної інформації. Мета таких дій — вплинути на громадську думку, посіяти паніку або змінити результати виборів.

У США зафіксували випадок, коли виборці отримували дзвінки із синтезованим голосом Джо Байдена, який закликав не йти голосувати на праймеріз. Аудіо створили за допомогою генератора голосу, а дзвінки поширювалися автоматично. Після розслідування FCC заборонила використання ШІ для таких автодзвінків.

Ознаки політичної ШІ-дезінформації:

- новина без джерела або з посиланням на фейковий сайт (наприклад, з доменом .xyz замість .gov.ua);

- синтезовані голоси у відео та аудіо, що звучать механічно;

- відсутність підтвердження інформації на офіційних ресурсах;

- масова поява однакових новин в анонімних Telegram-каналах або групах;

- емоційне забарвлення: страх, обурення, заклик до дій, образливі формулювання.

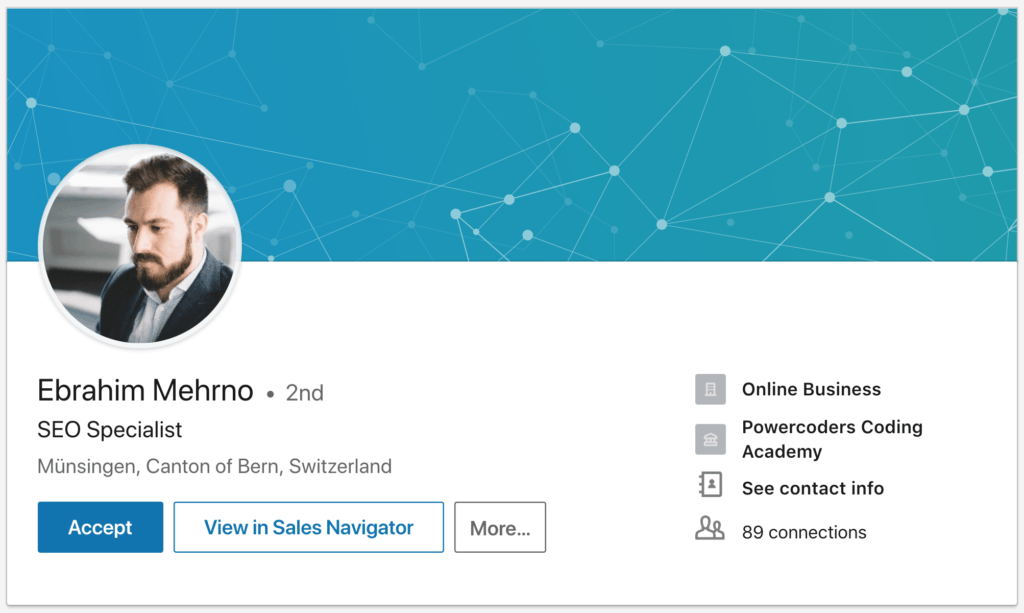

Фейкові LinkedIn-персони для B2B-знайомств або рекрутингових афер

Також шахраї навчилися використовувати ШІ для створення фейкових профілів у LinkedIn. Ці акаунти мають вигадані імена, досвід роботи, фото. Часто профілі маскуються під HR-менеджерів, керівників відділів, консультантів з інвестицій чи кібербезпеки.

Ці профілі можуть:

- пропонувати співпрацю або інвестиції з фіктивних компаній;

- вивідувати корпоративну інформацію через розмови або опитування;

- надсилати шкідливі файли під виглядом комерційних пропозицій;

- збирати CV та особисті дані кандидатів, прикриваючись фейковим рекрутингом.

У 2022–2024 роках були зафіксовані десятки випадків, коли компанії погоджувалися на онлайн-зустрічі з такими псевдофахівцями, а потім виявляли спроби проникнення в корпоративні пошти або CRM-системи.

Як розпізнати фейковий профіль у LinkedIn:

- профіль створений нещодавно, але вже має сотні зв’язків;

- незвичні поєднання досвіду — наприклад, керівник відділу без згадки компаній чи з однаковими описами у різних місцях роботи;

- шаблонні повідомлення без контексту;

- мінімальна інформація про компанію, яку представляє особа.

Щоб захистити себе від такого шахрайства:

- перевіряйте осіб через пошук зображень (наприклад, PimEyes або Google Зображення);

- звертайте увагу на цифровий слід — присутність у публікаціях, коментарях, блогах;

- не діліться комерційною або технічною інформацією до перевірки особи;

У разі сумнівів — спробуйте перейти на відеозв’язок або запитайте про їхню компанію й перевірте її існування.

Шахрайства з фейковим ІТ-аутсорсом або техпідтримкою, створені ШІ

Шахраї можуть використовувати ШІ для імітації роботи ІТ-фахівців, техпідтримки або розробників, щоб обдурити компанії та окремих працівників. Сценарій зазвичай виглядає просто: фейковий спеціаліст пише листа або звертається в LinkedIn чи Telegram, пропонуючи:

- терміново оновити безпеку на сайті чи CRM;

- допомогти з «проблемою» в обліковому записі Google, Microsoft, Amazon;

- перевірити сайт на вразливості або провести аудит безпеки.

У листі — текст, згенерований GPT, підписаний вигаданим експертом з професійним фото. У посиланні — скрипт, файл або форма, яка дає доступ до систем, облікових записів або документів.

Ознаки шахрайства:

- запити на встановлення скриптів або входи у ваші системи від малознайомих осіб;

- файли з розширенням .js, .html, .exe, або підозрілі Google Docs з посиланнями на сторонні ресурси;

- надмірний тиск або наголошення на терміновості;

- email з безкоштовного домену (gmail.com замість google.com) або новий профіль LinkedIn із підозрілою активністю.

Щоб не стати жертвою — не відкривайте файли чи посилання, навіть якщо вони виглядають професійно, без перевірки особи; перевіряйте особу через сайт компанії, з якої пишуть, або через колег; не передавайте паролі, API-ключі або доступи, поки не переконалися, що маєте справу з офіційним партнером чи перевіреним спеціалістом.

ШІ значно знижує поріг входу для таких атак — тепер шахрай може виглядати як розробник, аналітик або DevOps-інженер без технічної освіти, просто використовуючи генератор фото і GPT для листа.

Штучний інтелект став новим інструментом у руках шахраїв — він здатен генерувати фішингові листи, створювати фейкові особистості, підробляти документи й навіть клонувати голос. Завдяки цьому обман виглядає переконливо, а ризик потрапити в пастку — зростає щодня.

Щоб не стати жертвою, важливо зберігати пильність, перевіряти інформацію, не поспішати з рішеннями та навчати цьому своїх колег і близьких. Технології розвиваються — і наше критичне мислення має йти з ними в ногу.